LG Electronics presentará su robot doméstico ‘LG Cloid’ en el CES 2026, la exposición de electrodomésticos y TI más grande del mundo, que se inaugura en Las Vegas, EE. UU., el día 6 (hora local en EE. UU.).

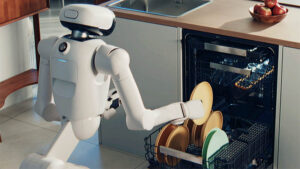

En el CES de este año, LG Cloid demuestra el papel y el potencial de los robots domésticos con IA. Actúa como un asistente personal, priorizando tareas según horarios y el entorno, controlando varios electrodomésticos en consecuencia e incluso realizando tareas domésticas.

El lanzamiento de Cloid forma parte de los esfuerzos de LG Electronics por lograr su objetivo principal de «Hogar sin trabajo, tiempo de calidad», liberando así a los clientes de las tareas domésticas. LG Electronics se ha dedicado a ofrecer productos y servicios que reducen la carga de las tareas domésticas. Algunos ejemplos incluyen electrodomésticos equipados con funciones de IA, electrodomésticos UP que ofrecen continuamente nuevas funciones de IA y servicios de suscripción que reducen la carga del mantenimiento de los electrodomésticos.

En el CES se presentó el “Zero Labor Home”, donde un robot doméstico controla electrodomésticos y realiza tareas del hogar según la situación.

Los visitantes pueden experimentar la apariencia detallada de ‘Zero Labor Home’, que se ha vuelto aún más cercana con LG Cloid.

Primero, Cloid prepara el desayuno para los residentes que están ocupados preparándose para ir a trabajar, siguiendo el plan de comidas que había preparado el día anterior. Saca leche del refrigerador y mete croissants en el horno. También entrega artículos como las llaves del auto y un control remoto para las presentaciones, según lo programado.

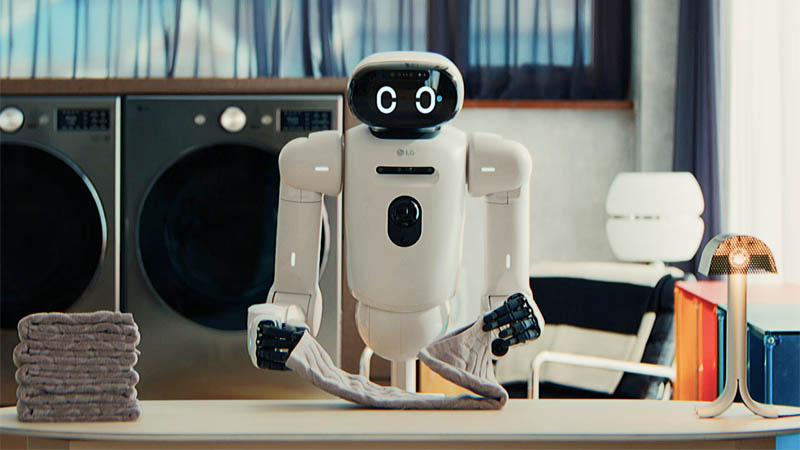

Después de que los residentes salen a trabajar, sacan la ropa del cesto y la colocan en la lavadora. También doblan y guardan las toallas lavadas. Cuando el robot de limpieza está en funcionamiento, también elimina los obstáculos en el recorrido de limpieza, garantizando una limpieza a fondo.

Además, demuestra preocupación por la vida diaria de los residentes al comunicarse con ellos y contar la cantidad de veces que levantan mancuernas durante el entrenamiento en casa.

Estos movimientos son posibles gracias a una combinación holística de la capacidad de percibir situaciones de manera compleja, la capacidad de aprender el estilo de vida de los ocupantes y la capacidad de controlar los movimientos con precisión.

Desarrollo de software central para robots que operan con precisión y entienden el lenguaje y la visión en un formato optimizado para las letras.

Cloid consta de una cabeza, un cuerpo con dos brazos y una parte inferior equipada con tecnología de conducción autónoma basada en ruedas. Puede ajustar su altura de 105 a 143 cm mediante el ángulo del respaldo, y sus brazos de aproximadamente 87 cm de largo pueden agarrar objetos desde el suelo o en altura.

Los dos brazos unidos al cuerpo se mueven con siete grados de libertad (GdL): tres movimientos de hombro (adelante y atrás/izquierda y derecha/rotación), un movimiento de codo (flexión y extensión) y tres movimientos de muñeca (adelante y atrás/izquierda y derecha/rotación). Esto equivale al movimiento de un brazo humano. Los cinco dedos también cuentan con articulaciones móviles individuales, lo que permite movimientos delicados. Esto permite que el robot funcione con fluidez en un entorno optimizado para el cuerpo humano.

La parte inferior del cuerpo incorpora un sistema de conducción autónoma con ruedas, desarrollado a partir de robots de limpieza, el Q9, robots de servicio y robots de reparto. El bajo centro de gravedad evita la pérdida de equilibrio incluso cuando niños o mascotas se cuelgan repentinamente del robot. Además, el robot minimiza el balanceo, lo que permite movimientos precisos y libres de la parte superior del cuerpo. Su precio asequible, en comparación con los robots bípedos, también lo convierte en una ventaja para su comercialización.

La cabeza funciona como el «LG Q9», desarrollado como un centro móvil de IA para el hogar. Equipado con un chipset, una pantalla, altavoces, una cámara, varios sensores e IA generativa basada en voz, el cerebro robótico le permite comunicarse con humanos mediante lenguaje y expresiones faciales, conocer el estilo de vida y el entorno de los ocupantes, y controlar electrodomésticos con base en esta información.

LG Electronics aplicó sus tecnologías de Modelo de Lenguaje de Visión (VLM) y Acción de Lenguaje de Visión (VLA) de desarrollo propio a sus chipsets. Basada en un modelo físico de IA, esta tecnología ha sido optimizada para robots domésticos, entrenados con decenas de miles de horas de datos de tareas domésticas.

Para que un robot se mueva de forma eficaz y adecuada en una situación dada, se requieren tecnologías VLM y VLA. VLM interpreta la información visual en lenguaje e integra comandos verbales con información visual para proporcionar una comprensión integral. VLA utiliza esta información visual y verbal integrada para que el robot pueda planificar y ejecutar acciones específicas.